AVIS ET CONSULTATION DU PERSONNEL DE L'ACS 11-348 LA RÉVOLUTION DE L'INFORMATIQUE : REDÉFINIR LE DROIT CANADIEN DES VALEURS MOBILIÈRES

PARTIE 2 - CONSEILS AUX DÉCLARANTS

(Pour les courtiers, les conseillers et les gestionnaires de fonds d'investissement et les fonds de la série 81 qu'ils gèrent)

Brian Koscak, vice-président de la PCMA

Cet article est la deuxième partie d'une série de trois articles consacrés à l'examen de l'action des Autorités canadiennes en valeurs mobilières (ACVM). (CSA)) publication de Avis et consultation du personnel du CSA 11-348 - Applicabilité des lois canadiennes sur les valeurs mobilières et utilisation des systèmes d'intelligence artificielle sur les marchés des capitaux (le Avis). Le présent article examine l'application spécifique de la communication aux gestionnaires de fonds d'investissement (OIF), les concessionnaires et les conseillers (collectivement, Registrants).

La première partie aborde les grands thèmes identifiés par les ACVM, notamment la neutralité technologique dans la réglementation des valeurs mobilières, l'intelligence artificielle (AI), la gouvernance et la surveillance, les exigences en matière d'explicabilité, les obligations de divulgation et la gestion des conflits d'intérêts liés à l'IA. Vous pouvez accéder à la partie 1 ici.

Cette série d'articles vise à fournir à certains participants au marché[1] avec une compréhension approfondie de la façon dont les lois canadiennes sur les valeurs mobilières réglementent "Systèmes d'IA"[2] sur nos marchés de capitaux et les obligations qui en découlent.

REGISTRANTS

(a) Obligations générales

La façon dont les ACVM traitent les obligations des déclarants représente un équilibre entre l'innovation et la réglementation. Tout en maintenant l'exigence fondamentale que les activités liées à l'investissement nécessitent un enregistrement, l'avis reconnaît que l'IA modifie la manière dont ces activités sont exercées.

Bien que la norme nationale 31-103 Exigences d'enregistrement, exemptions et obligations permanentes des déclarants (NI 31-103) reste la pierre angulaire de la réglementation des titulaires, son application aux systèmes d'IA nécessite une interprétation approfondie et prudente pour garantir une mise en œuvre efficace. La position de la CSA selon laquelle l'automatisation ne modifie pas l'obligation de rendre des comptes est particulièrement remarquable. Que ce soit un humain ou un système d'IA qui prenne les décisions, les titulaires restent liés par la norme générale de diligence qui exige l'équité, l'honnêteté et la bonne foi dans les relations avec les clients.

L'avis précise que les membres de l'Organisme canadien de réglementation des investissements (CIRO) doivent se conformer à la fois aux exigences du CIRO et à celles de la législation applicable en matière de valeurs mobilières, ce qui crée une structure de surveillance complète pour le déploiement de l'IA dans les entreprises enregistrées.

(b) Demande d'enregistrement ou mise à jour des informations relatives à l'enregistrement - Dépôts requis

Les entreprises qui demandent l'enregistrement doivent décrire leurs plans d'entreprise, y compris les modèles d'exploitation qui impliquent des systèmes et une utilisation de l'IA. En permanence, les déclarants doivent également mettre à jour leurs déclarations s'ils ajoutent des systèmes et une utilisation de l'IA à leurs activités et opérations susceptibles d'avoir une incidence sur les services enregistrables fournis aux clients.

L'avis indique que les membres des ACVM examineront les risques que les systèmes d'IA font peser sur l'activité de la personne inscrite et sur ses clients, et demanderont probablement des informations détaillées sur les plans de déploiement de l'IA. Il ne s'agit pas d'un processus d'approbation automatique, les ACVM sont prêtes à imposer des conditions personnalisées aux entreprises qui utilisent des systèmes d'IA.

L'avis encourage un engagement précoce avec les membres du CSA. Les entreprises qui envisagent de déployer l'IA sont "fortement encouragés à contacter le personnel à un stade précoceune exigence qui pourrait contribuer à prévenir les problèmes avant qu'ils ne surviennent. Il s'agit d'une approche collaborative de la réglementation qui reconnaît la complexité de l'intégration de l'IA.

(c) Gains d'efficacité opérationnelle (administration de back-office)

L'approche des ACVM en matière d'efficacité opérationnelle est pragmatique. Elles reconnaissent que les systèmes d'IA peuvent améliorer les opérations de back-office, de la gestion des risques à la cybersécurité, en passant par la protection des informations sur les clients et les rapports réglementaires/clients. Comme indiqué dans l'avis,

"Les systèmes d'IA peuvent aider les conseillers et les revendeurs à effectuer des recherches sur la connaissance du produit, la connaissance du client (KYC), la collecte d'informations et les processus d'accueil des clients sont plus efficaces et peuvent aider les déclarants à faire de meilleures recommandations ou à prendre de meilleures décisions d'investissement pour leurs clients.."

La CSA insiste sur le fait que les gains d'efficacité doivent être équilibrés par des structures de gouvernance. Le message est clair : l'automatisation pour l'automatisation n'est pas l'objectif. Toute amélioration de l'efficacité induite par l'IA doit être mise en œuvre dans un cadre garantissant une surveillance et une gestion des risques appropriées.

(d) Structure de conformité et système de contrôle

Comme indiqué dans l'avis, les ACVM exigent des entreprises qu'elles maintiennent un système de contrôle et de supervision qui donne une assurance raisonnable du respect de la législation sur les valeurs mobilières et d'une gestion prudente des risques. Les personnes inscrites doivent disposer de politiques et de procédures adaptées (P&P) qui traitent spécifiquement des défis uniques posés par l'IA. En outre, les titulaires doivent tenir des livres et des registres sur la prise de décision en matière d'IA et fournir un rapport sur l'état d'avancement de la mise en œuvre de l'IA.degré approprié d'explicabilité"pour satisfaire aux exigences du règlement 31-103 en matière de tenue de registres.

Il ne s'agit pas de modifier les cadres de P&P existants, mais de développer de nouvelles approches capables de relever les défis uniques posés par l'IA. Des protocoles de test aux systèmes de surveillance, les déclarants devront peut-être repenser la manière dont la conformité aux lois et règlements sur les valeurs mobilières fonctionne dans un monde fondé sur l'IA.

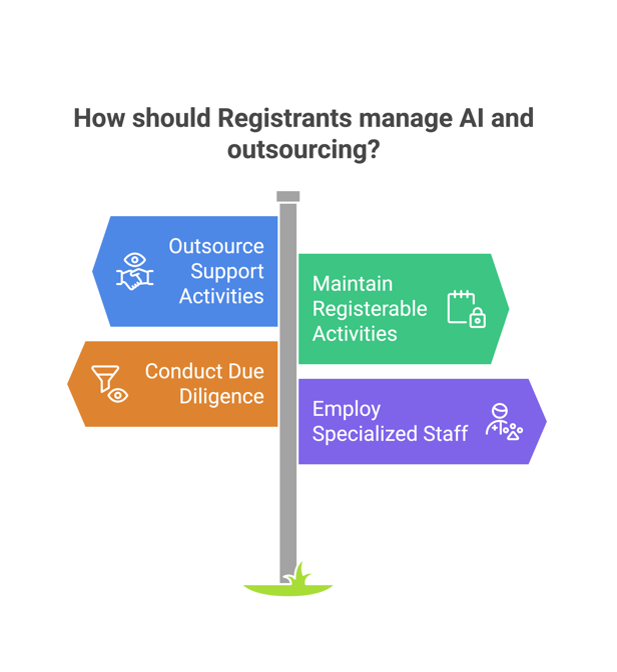

(e) Externalisation

Les ACVM reconnaissent que de nombreux titulaires peuvent vouloir faire appel à des prestataires de services tiers (y compris des sociétés affiliées) qui utilisent le système AI. Cependant, la CSA trace une ligne claire : vous pouvez externaliser les activités de soutien, mais vous ne pouvez pas externaliser l'activité enregistrable. Il ne s'agit pas d'une nouveauté, mais d'une distinction qui influencera la manière dont les titulaires abordent leurs systèmes d'IA.

L'avis rappelle que les déclarants doivent faire preuve d'une grande diligence avant de sous-traiter des services (y compris des services basés sur des systèmes d'IA ou améliorés par ces derniers) et superviser en permanence les prestataires de services. Il s'agit d'un processus continu de surveillance et de vérification.

En outre, les ACVM exigent des personnes inscrites qu'elles disposent d'employés ou de conseillers spécialisés dans l'IA et les exigences de conduite des personnes inscrites. Il ne suffit pas de comprendre la technologie ou l'inscription et la réglementation des valeurs mobilières, une entreprise a besoin de personnes qui comprennent les deux. Cette exigence pourrait entraîner des changements importants dans la façon dont les personnes inscrites dotent en personnel leurs initiatives en matière d'IA.

(f) Conflits d'intérêts

L'approche des ACVM à l'égard des conflits d'intérêts liés à l'IA impliquant des personnes inscrites (c'est-à-dire à la fois des entreprises et des personnes inscrites) s'appuie sur le cadre traditionnel des conflits d'intérêts établi dans le Règlement 31-103 et son instruction complémentaire (articles 13.4 et 13.4.1 du Règlement 31-103). Les personnes inscrites doivent identifier et traiter les conflits importants, mais les systèmes d'IA introduisent de nouvelles complications, qu'il s'agisse d'algorithmes potentiellement biaisés ou d'interactions complexes entre systèmes automatisés qui peuvent ne pas être immédiatement apparentes. Nous rappelons aux personnes inscrites leurs obligations en matière de tenue de registres en vertu des articles 11.5 et 11.6 du Règlement 31-103.

L'avis donne des exemples précis de conflits liés à l'IA que les entreprises doivent surveiller, notamment les données non objectives qui pourraient donner lieu à des recommandations ou à des décisions biaisées favorisant certains clients sur la base de caractéristiques démographiques ou en faveur de produits exclusifs sans examen approprié des autres solutions possibles. L'un des principaux points d'intérêt des recommandations des ACVM est la nécessité potentielle d'explorer et de mettre en œuvre d'autres méthodes de test et de surveillance spécialement conçues pour les systèmes d'IA qui ne sont pas entièrement explicables, ce qui permettrait de relever les défis potentiels auxquels sont confrontées les personnes inscrites.

Pour résoudre ces conflits, la CSA propose d'utiliser des analyses statistiques, des algorithmes de détection de modèles et même des systèmes d'IA conçus pour détecter les préjugés dans d'autres systèmes d'IA. (c'est-à-dire, L'examen de l'IA de l'IA). Il s'agit d'une approche technologique de la réglementation des valeurs mobilières qui reconnaît que la meilleure façon de contrôler l'IA est parfois d'utiliser davantage d'IA, bien entendu dans le cadre d'une gouvernance appropriée.

CONSEILLERS ET NÉGOCIANTS

Le régime canadien d'enregistrement des valeurs mobilières exige un double enregistrement pour les entreprises et les représentants individuels qui fournissent des services enregistrables (c'est-à-dire, le conseil et la négociation de valeurs mobilières). Ce cadre est conçu pour protéger les investisseurs qui se fient aux conseils et aux décisions d'un représentant inscrit. Les représentants inscrits doivent maintenir des normes de compétence élevées et rester responsables de leurs recommandations d'investissement, que les systèmes d'IA jouent un rôle de soutien ou un rôle principal dans la prestation de services.

Les conseillers et les courtiers qui utilisent des applications d'IA dans le cadre de leurs activités doivent mettre en œuvre des protocoles de test adaptés au rôle de chaque système, y compris des plans d'urgence pour les opérations si des lacunes importantes sont détectées pendant les tests. Les tests doivent avoir lieu avant et après en assurant un suivi permanent des performances et de la fiabilité du système d'IA.

Il est également essentiel que les clients soient clairement informés de l'utilisation des systèmes d'IA et des risques qui y sont associés. Comme l'indique l'avis,

"Il sera important de divulguer aux clients, de manière claire et significative, toute utilisation des systèmes d'IA susceptible d'affecter directement les services enregistrables qui leur sont fournis, ainsi que les risques associés, conformément aux obligations d'information sur les relations prévues à l'article 14.2 du Règlement 31-103 et à l'obligation de traiter équitablement, honnêtement et de bonne foi avec les clients".

L'avis présente un certain nombre de cas d'utilisation des systèmes d'IA par les déclarants, qui sont examinés ci-dessous.

(a) Exécution des opérations

Si les ACVM reconnaissent que l'IA peut rendre l'exécution des transactions plus efficace, notamment grâce à des outils d'amélioration de la qualité d'exécution, l'avis souligne que la responsabilité de l'activité enregistrable reste inchangée. Que ce soit un humain ou une IA qui exécute les transactions, les mêmes obligations fondamentales s'appliquent.

La CSA reconnaît que les systèmes d'IA peuvent améliorer l'accès direct au marché (DMA), mais insiste sur le maintien d'une surveillance humaine. L'exigence de "explicabilité appropriée"est important. La CSA stipule qu'il doit y avoir suffisamment de transparence pour que les contrôleurs humains puissent détecter et corriger les erreurs en temps utile (c'est-à-dire, garder "les humains dans la boucle").

L'avis aborde également la relation entre l'exécution pilotée par l'IA et les risques de manipulation du marché. Les entreprises doivent s'assurer que leurs systèmes d'IA ne se livrent pas à des pratiques de négociation manipulatrices, même involontairement. Cette attente pourrait influencer de manière significative la manière dont les algorithmes de négociation sont conçus et contrôlés.

(b) KYC et Onboarding

Tout en reconnaissant le potentiel de l'IA pour améliorer la collecte d'informations KYC, les ACVM maintiennent l'exigence de "une interaction significative"entre les clients et les déclarants. Il ne s'agit pas nécessairement de réunions en face à face. L'avis reconnaît que des interactions significatives peuvent avoir lieu par le biais de divers moyens, y compris les communications médiatisées par la technologie (c'est-à-dire, courriels et appels Zoom).

Le traitement des processus automatisés est particulièrement nuancé. Les ACVM autorisent les processus automatisés de connaissance du client dans certaines circonstances, comme dans le cas des conseillers en ligne opérant sous le nom de "appeler en cas de besoinLe modèle de l'" assurance de la qualité " est un modèle à part entière. Toutefois, cela s'accompagne d'importantes mises en garde : il doit y avoir suffisamment d'explicabilité pour qu'un contrôle humain puisse surveiller et corriger les erreurs en temps voulu, et la technologie doit faciliter et non remplacer une interaction significative avec le client.

Les exigences en matière de protection de la vie privée et de confidentialité font l'objet d'une attention particulière dans ce contexte. L'avis souligne que si l'IA peut améliorer les processus KYC, les titulaires doivent assurer une protection solide des informations relatives aux clients. Il rappelle que l'innovation technologique ne peut se faire au détriment de la vie privée des clients.

(c) Soutien aux clients

Le point de vue des ACVM sur le support client alimenté par l'IA représente une adoption pratique de l'innovation. Elles reconnaissent le rôle des chatbots et autres systèmes d'assistance automatisés dans la facilitation des fonctions générales d'assistance aux clients, y compris le traitement des plaintes. Toutefois, cette reconnaissance s'accompagne d'une mise en garde cruciale : ces systèmes doivent fournir des informations exactes de manière cohérente.

L'avis établit des distinctions importantes entre les différents types de fonctions d'assistance aux clients. Si l'IA peut traiter les demandes de renseignements et les informations de routine, les interactions plus complexes, en particulier celles qui impliquent des conseils en matière d'investissement ou la résolution de plaintes, nécessitent une supervision humaine appropriée. Il s'agit d'une approche graduelle qui adapte le niveau d'automatisation à la complexité et au risque de la tâche.

Les ACVM insistent sur la nécessité d'une surveillance et d'une vérification continues des systèmes de soutien alimentés par l'IA. Les sociétés inscrites doivent tester régulièrement ces systèmes pour s'assurer qu'ils fournissent des informations exactes et qu'ils transmettent de manière appropriée les problèmes complexes au personnel humain. Cette exigence pourrait influencer la manière dont les entreprises inscrites abordent l'automatisation du service à la clientèle.

(d) Aide à la décision

Le traitement par les ACVM de l'IA dans la prise de décision en matière d'investissement est nuancé. Elles reconnaissent le potentiel de l'IA à améliorer la prise de décision en recueillant et en analysant efficacement les informations, y compris en s'appuyant sur un plus large éventail de sources que ce qui est humainement possible. Toutefois, elles précisent que l'IA doit soutenir, et non remplacer, le jugement humain dans les décisions d'investissement (une fois de plus, le "l'homme dans la boucle").

L'avis donne des exemples précis de fonctions de soutien acceptables de l'IA, allant de la prévision des mouvements du marché au contrôle des données d'entrée prescrites en vue de détecter des changements dans les critères pertinents. L'accent mis sur la vérification est particulièrement remarquable : Les ACVM soulignent que les personnes inscrites doivent prendre des mesures raisonnables pour vérifier la qualité et l'exactitude des informations générées par l'IA avant d'agir en conséquence.

Les ACVM rappellent aux personnes inscrites que les opérations doivent en fin de compte être recommandées ou dirigées par une personne inscrite, et non par le système d'IA. Comme l'indiquent les ACVM, elles exigent que les personnes inscrites " [ ?traiter les informations [IA] comme une simple donnée d'entrée pour leur propre prise de décision, de sorte que les transactions sont en fin de compte recommandées ou dirigées par le [R]egistrant." Cela permet de maintenir des lignes de responsabilité claires tout en permettant aux déclarants d'exploiter les capacités analytiques de l'IA.

(e) Décisions automatisées limitées

Les ACVM autorisent un nombre limité de prises de décision automatisées par l'IA tout en imposant des exigences strictes en matière de surveillance. Elles reconnaissent que les systèmes d'IA peuvent exécuter certaines décisions automatiquement, comme le rééquilibrage de portefeuille ou la couverture dynamique, à condition que ces décisions s'inscrivent dans le cadre de contraintes étroitement prescrites et fassent l'objet d'une surveillance humaine appropriée.

Le traitement des différents types de décisions automatisées est particulièrement complexe. L'avis établit une distinction entre les décisions prises pour le compte propre de l'entreprise et celles prises pour les comptes des clients, les exigences étant plus strictes pour ces dernières. Lorsqu'il s'agit de comptes clients, les ACVM exigent un degré élevé d'explicabilité afin de garantir que les personnes inscrites disposent d'une compréhension et d'un contrôle suffisants.

L'avis exige des titulaires qu'ils consultent les membres de la CSA bien avant de lancer tout système de prise de décision automatisée. Il ne s'agit pas seulement d'une question de notification ; les ACVM attendent des personnes inscrites qu'elles démontrent que toutes les préoccupations (celles décrites dans l'avis et toute autre apparaissant au cours de la consultation) ont été pleinement prises en compte. Il s'agit d'une approche collaborative de la réglementation des valeurs mobilières qui pourrait contribuer à prévenir les problèmes avant qu'ils ne surviennent.

GESTION DE PORTEFEUILLE

Les ACVM adoptent la position la plus ferme en ce qui concerne la gestion de portefeuille par IA entièrement autonome. Au stade actuel du développement de l'IA, elles considèrent qu'il est effectivement impossible pour un titulaire utilisant un tel système de satisfaire de manière cohérente aux exigences réglementaires ou d'obtenir de manière fiable les résultats souhaités pour les clients. Il s'agit d'une position forte qui pourrait influencer de manière significative la manière dont l'IA est déployée dans la gestion de patrimoine.

L'avis reconnaît que si l'IA peut appuyer les décisions de gestion de portefeuille, elle ne peut pas remplacer le jugement des représentants-conseils. Cela permet de maintenir les normes les plus élevées en matière de compétence et de conduite des titulaires pour les services de gestion discrétionnaire des investissements. Il reconnaît que certains aspects des services financiers requièrent encore le jugement et la responsabilité de l'homme.

Ce qui rend cet avis particulièrement puissant, c'est le défi implicite qu'il lance au secteur : prouver que l'IA peut satisfaire à ces normes avant de tenter une gestion de portefeuille entièrement autonome. Plutôt que de dire simplement "non", les ACVM ont établi des critères clairs que les futurs systèmes d'IA devront respecter.

GESTIONNAIRES DE FONDS D'INVESTISSEMENT ET INSTRUMENTS NATIONAUX DE LA SÉRIE 81 IMPLIQUANT DES FONDS D'INVESTISSEMENT ÉMETTEURS ASSUJETTIS

Un GFI dirige les activités, les opérations ou les affaires d'un fonds d'investissement. Les GFI sont souvent enregistrés dans une autre catégorie d'enregistrement, comme celle de gestionnaire de portefeuille et/ou de courtier sur le marché réglementé. Par conséquent, les GFI ont souvent plusieurs casquettes. Cela signifie que les GFI doivent naviguer entre plusieurs couches d'exigences réglementaires lorsqu'ils mettent en œuvre des systèmes d'IA, une complexité que les ACVM abordent de front.

L'avis reconnaît que les gestionnaires de fonds peuvent utiliser des systèmes d'intelligence artificielle pour s'acquitter de leurs obligations fiduciaires par le biais de fonctions de suivi de portefeuille, de gestion des risques et de conformité, mais il précise qu'ils doivent exercer une surveillance rigoureuse pour s'assurer que ces systèmes fonctionnent de manière transparente, qu'ils sont explicables et qu'ils sont exempts de préjugés et de conflits d'intérêts. Si les GFI peuvent développer ou externaliser des systèmes d'IA, leur responsabilité fiduciaire fondamentale à l'égard des fonds qu'ils gèrent (c'est-à-dire, ) restent inchangées, exigeant d'eux qu'ils comprennent et supervisent activement tout outil d'IA utilisé dans la gestion des fonds pour atteindre les objectifs d'investissement et maintenir la conformité avec les obligations réglementaires.

L'avis indique que la législation sur les valeurs mobilières, y compris les instruments nationaux de la série 81 concernant les fonds d'investissement, prescrit des exigences opérationnelles et d'information pour les fonds d'investissement qui sont des émetteurs assujettis. Les gestionnaires de fonds d'investissement sont également soumis à une norme de diligence. L'utilisation de systèmes d'IA par les GFI et les fonds d'investissement serait soumise à ces dispositions applicables. En conséquence, la communication fournit des orientations concernant les fonds d'investissement qui sont des émetteurs assujettis, comme indiqué ci-dessous.

(a) Obligations de divulgation (éviter l'"AI Washing")

L'approche des ACVM en matière d'information sur l'IA pour les gestionnaires de fonds d'investissement est détaillée. Si un GFI utilise l'IA pour atteindre les objectifs et stratégies d'investissement d'un fonds, cette utilisation doit être clairement indiquée dans les documents d'offre du fonds d'investissement (c'est-à-dire, le prospectus et les documents récapitulatifs tels que l'aperçu du fonds/de l'ETF, le cas échéant). Les ACVM attendent des GFI qu'ils définissent ce qu'ils entendent par "IA" et qu'ils expliquent exactement comment ces systèmes sont intégrés dans le processus de gestion de portefeuille du fonds.

Les commentaires des ACVM sur la commercialisation de l'IA revêtent une importance particulière. Si l'utilisation de l'IA par un fonds est présentée comme une stratégie d'investissement importante, elle doit être divulguée en tant qu'objectif d'investissement, ce qui déclenche des obligations réglementaires spécifiques en vertu du Règlement 81-102. Il ne s'agit pas seulement de transparence, mais aussi de s'assurer que les fonds d'investissement ne peuvent pas utiliser l'IA comme un gadget de marketing sans l'étayer par des éléments concrets.

L'avis vise directement "Lavage à l'IALes gestionnaires de fonds doivent fournir des informations claires et précises sur la manière dont les systèmes d'IA sont utilisés et intégrés dans les opérations des fonds. Les gestionnaires de fonds d'investissement doivent fournir des informations claires et précises sur la manière dont les systèmes d'IA sont utilisés et intégrés dans les opérations des fonds. Cette exigence pourrait influencer la manière dont les fonds d'investissement commercialisent leurs capacités en matière d'IA.

(b) Facteurs de risque

Les ACVM exigent des gestionnaires de fonds d'investissement qu'ils incluent une information appropriée sur les risques liés à l'utilisation des systèmes d'IA dans les documents d'offre d'un fonds d'investissement. Toutefois, ces informations doivent être proportionnées à l'utilisation réelle des systèmes d'IA et fournies dans le contexte des objectifs et stratégies d'investissement du fonds d'investissement. Il ne suffit pas d'inclure des avertissements passe-partout sur les risques liés à l'IA. De la dérive des modèles aux problèmes de qualité des données, les ACVM attendent des fonds d'investissement qu'ils identifient et expliquent les risques spécifiques à l'IA susceptibles d'affecter le rendement ou les opérations du fonds.

Les normes CSA soulignent que les informations sur les risques doivent être significatives et pertinentes pour les investisseurs. Les ACVM indiquent en fait que les gestionnaires de fonds d'investissement doivent expliquer les risques liés à l'IA dans des termes que les investisseurs peuvent comprendre et utiliser pour prendre des décisions éclairées. Cette exigence pourrait améliorer la qualité de l'information sur les risques liés à l'IA dans les documents des fonds d'investissement.

(c) Changements fondamentaux

Le traitement par les ACVM des changements fondamentaux liés à l'IA est particulièrement intéressant car il reconnaît que l'intégration de l'IA peut être plus qu'une simple mise à jour technique ; elle peut modifier fondamentalement le mode de fonctionnement d'un fonds. Si le déploiement de systèmes d'IA par un fonds existant est considéré comme une stratégie d'investissement importante, il doit être divulgué en tant qu'objectif d'investissement et doit être approuvé par les détenteurs de titres avant d'être mis en œuvre, comme l'exige la loi sur les valeurs mobilières applicable.

L'avis rappelle aux gestionnaires de fonds que lorsque l'intégration de l'IA constitue un changement important, celui-ci doit faire l'objet d'une notification publique dans le cadre du régime de déclaration de changement important. Il ne s'agit pas seulement d'une question de paperasserie, mais de s'assurer que les changements importants dans le mode de fonctionnement d'un fonds sont correctement communiqués aux investisseurs et au marché.

Plus important encore, les ACVM exigent des GFI qu'ils examinent attentivement si l'ajout de systèmes d'IA constitue un changement fondamental nécessitant l'approbation des actionnaires. Cette exigence pourrait influencer de manière significative la façon dont les GFI abordent l'adoption de l'IA, ce qui pourrait conduire à des mises en œuvre plus progressives et bien communiquées plutôt qu'à des changements technologiques soudains.

(d) Communication sur les ventes

L'avis stipule qu'un GFI ne peut pas faire de déclarations fausses ou trompeuses sur l'utilisation de l'IA dans toute forme de matériel de marketing, qu'il s'agisse du contenu d'un site web ou d'une publication sur les médias sociaux. Par exemple, les ACVM exigent une présentation équilibrée. Si les communications commerciales d'un fonds vantent les avantages de l'utilisation des systèmes d'IA, elles doivent accorder la même importance aux risques et aux limites qui y sont associés. Les ACVM disent en fait qu'il ne faut pas se contenter de mettre en avant les avantages de l'IA, mais qu'il faut raconter toute l'histoire (c'est-à-direles risques ou les inconvénients).

Les ACVM exigent également que les gestionnaires de fonds disposent de procédures d'examen des documents de marketing relatifs à l'IA. Ces examens doivent permettre de s'assurer que les affirmations relatives à l'utilisation de l'IA sont véridiques, non exagérées et conformes aux documents réglementaires. Cette exigence pourrait avoir une incidence sur la manière dont les fonds commercialisent leurs capacités en matière d'IA.

(e) Utilisation des indices AI par les fonds d'investissement

Les ACVM reconnaissent que les fournisseurs d'indices peuvent utiliser des systèmes d'intelligence artificielle pour générer la composition des indices, mais elles précisent que les gestionnaires de fonds doivent établir des critères clairs pour déterminer quand ces indices peuvent être utilisés par des fonds d'investissement passifs. Les principales exigences portent sur la transparence et l'absence de pouvoir discrétionnaire.

Les ACVM précisent que si un indice généré par l'IA ne peut pas satisfaire aux exigences de transparence et de composition fondée sur des règles, les fonds qui le suivent ne peuvent pas être commercialisés en tant que fonds indiciels. Ils doivent au contraire être traités comme des fonds gérés activement, une distinction qui a des implications en termes de marketing et d'exigences réglementaires.

L'accent mis sur la transparence de la méthodologie des indices est remarquable. Les fonds doivent être en mesure d'expliquer non seulement ce que fait l'indice, mais aussi comment il le fait. Cela pourrait influencer la manière dont l'IA est utilisée dans la construction de l'indice et potentiellement conduire au développement de systèmes d'IA plus explicables dans ce domaine.

(f) Conflits d'intérêts

L'approche des ACVM en matière de conflits d'intérêts liés à l'IA pour les GFI s'appuie sur les cadres existants, énoncés dans le Règlement 81-107 sur les conflits d'intérêts liés à l'IA (Règlement 81-107 sur les conflits d'intérêts liés à l'IA). Comité d'examen indépendant des fonds d'investissementtout en reconnaissant de nouveaux défis. L'obligation de créer un comité d'examen indépendant (IRC) sur les questions de conflit liées à l'IA ajoute une couche importante de gouvernance à la manière dont ces systèmes sont déployés et exploités.

L'avis exige que les gestionnaires de fonds identifient et soumettent tout conflit d'intérêts réel ou perçu lié à l'utilisation de l'IA au CEI de leur fonds pour approbation ou recommandation avant d'utiliser ces systèmes. Il ne s'agit pas seulement de conflits traditionnels, mais aussi de comprendre comment les systèmes d'IA peuvent créer de nouveaux types de conflits qui n'étaient pas possibles dans un monde antérieur à l'IA.

Les ACVM insistent sur le fait que les GFI doivent disposer d'un processus permettant d'identifier et de gérer en permanence les conflits liés à l'IA. Ces processus doivent comprendre un suivi et des tests réguliers des systèmes d'IA afin de s'assurer qu'ils ne créent pas ou n'exacerbent pas les conflits d'intérêts. Cette exigence pourrait influencer la manière dont les fonds abordent la gouvernance et la surveillance de l'IA.

Conclusion

L'IA transforme le paysage canadien des valeurs mobilières, et l'approche adoptée par les ACVM dans l'avis reflète un effort concerté pour équilibrer l'innovation et la protection des investisseurs. La partie 2 de cette série en trois parties souligne comment les obligations fondamentales imposées aux personnes inscrites, y compris les GFI, les courtiers et les conseillers, perdurent même face à l'évolution des capacités de l'IA. Qu'il s'agisse de renforcer l'efficacité du back-office, d'améliorer l'exécution des transactions, de fournir des processus KYC plus robustes ou d'augmenter le soutien à la clientèle, le message de l'ASC reste cohérent : L'IA doit servir d'outil pour augmenter le jugement humain et non le remplacer. L'obligation de rendre compte, la supervision et le contrôle continu sont des éléments essentiels des attentes de la CSA.

L'avis souligne qu'il est attendu des inscrits qu'ils mettent en place des procédures et des procédures garantissant que les activités basées sur l'IA sont conformes aux exigences existantes en matière de réglementation des valeurs mobilières. Les informations doivent être significatives et transparentes, les conflits d'intérêts doivent être identifiés et évités ou atténués, et les risques liés à l'IA doivent être clairement communiqués aux clients et aux investisseurs. Pour les GFI, la mise en garde des ACVM contre le "lavage" de l'IA, qui consiste à promouvoir l'IA en tant que stratégie de fonds sans soutien substantiel, illustre la priorité accordée à une commercialisation qui n'est pas trompeuse et à une divulgation équilibrée des risques.

Alors que le secteur canadien des valeurs mobilières continue d'intégrer des solutions d'IA, l'approche proposée par les ACVM soutient non seulement l'innovation responsable en matière d'IA, mais vise également à maintenir les normes élevées de protection des investisseurs qui sous-tendent la réglementation des valeurs mobilières. En favorisant un engagement précoce avec les organismes de réglementation, en mettant l'accent sur des structures de conformité solides et en établissant des attentes claires pour les activités liées à l'IA, les ACVM facilitent un avenir dans lequel la technologie peut prospérer tout en préservant les principes fondamentaux de la réglementation. La troisième partie de cette série approfondira ces thèmes et donnera un aperçu supplémentaire de l'évolution de la position des ACVM sur le rôle de l'IA dans les marchés financiers canadiens.

Prochaines étapes

La troisième partie de cette série d'articles traite de l'application de la communication aux sociétés publiques qui ne sont pas des fonds d'investissement (c'est-à-direLe présent document s'adresse aux émetteurs assujettis qui ne sont pas des fonds d'investissement, tels que les FPI, les émetteurs assujettis du secteur minier, de la biotechnologie ou de l'infrastructure.) Il aborde les aspects spécifiques que les émetteurs assujettis doivent prendre en compte lors de la mise en œuvre de systèmes d'IA, notamment les obligations d'information et la gestion de l'information importante liée à leurs initiatives en matière d'IA.

Première partie de cette série aborde les thèmes généraux identifiés par les ACVM dans leur examen des systèmes d'IA et du droit canadien des valeurs mobilières.

La période de consultation de la CSA se termine le 30 mars 2025. La consultation donne aux parties prenantes du secteur l'occasion de façonner l'évolution de la réglementation de l'IA sur les marchés financiers canadiens. Par ce processus de consultation, les ACVM cherchent à favoriser l'innovation responsable en matière d'IA tout en maintenant l'intégrité du marché et la protection des investisseurs. Les questions posées dans l'avis sont présentées ci-dessous.

Avis CSA Questions de consultation

- Existe-t-il des cas d'utilisation des systèmes d'IA qui, selon vous, ne peuvent être pris en compte sans règles nouvelles ou modifiées, ou sans exemptions ciblées des règles actuelles ? Veuillez préciser les changements que vous jugez nécessaires.

- Faut-il prévoir des règles et/ou des orientations nouvelles ou modifiées pour traiter les risques liés à l'utilisation des systèmes d'IA sur les marchés de capitaux, notamment en ce qui concerne les approches de gestion des risques pour le cycle de vie des systèmes d'IA ? Les entreprises doivent-elles élaborer de nouveaux cadres de gouvernance ou peuvent-elles adapter les cadres existants ? Devrions-nous envisager d'adopter des mesures ou des normes de gouvernance spécifiques (par exemple, la ligne directrice E-23 du BSIF sur la gestion du risque de modèle, l'ISO, le NIST) ?

- Les données jouent un rôle essentiel dans le fonctionnement des systèmes d'IA et constituent la base sur laquelle leurs résultats sont créés. Quelles considérations les participants au marché devraient-ils garder à l'esprit lorsqu'ils déterminent les sources de données à utiliser pour les systèmes d'IA qu'ils déploient (p. ex. la confidentialité, l'exactitude, l'exhaustivité) ? Quelles mesures les participants au marché devraient-ils prendre lorsqu'ils utilisent des systèmes d'IA afin de tenir compte des risques uniques liés aux sources de données utilisées par les systèmes d'IA (p. ex. des mesures qui amélioreraient la confidentialité, l'exactitude, la sécurité, la qualité et l'exhaustivité des données) ?

- Quel rôle les humains doivent-ils jouer dans la surveillance des systèmes d'IA (par exemple, "l'humain dans la boucle") et comment ce rôle doit-il être intégré dans le cadre de gouvernance de l'IA d'une entreprise ? Y a-t-il certaines utilisations des systèmes d'IA sur les marchés financiers pour lesquelles l'implication humaine directe dans la surveillance des systèmes d'IA est plus importante que d'autres (par exemple, les cas d'utilisation reposant sur des techniques d'apprentissage automatique qui peuvent avoir des degrés d'explicabilité moindres) ? En fonction du système d'IA, quelles sont les compétences, les connaissances, la formation et l'expertise nécessaires ? Veuillez fournir des détails et des exemples.

- Est-il possible de surveiller efficacement et en continu les systèmes d'IA afin d'identifier les variations dans les résultats des modèles en utilisant un développement fondé sur des tests, y compris des tests de résistance, des examens post-négociation, des vérifications ponctuelles et des mesures correctives de la même manière que les algorithmes de négociation fondés sur des règles afin d'atténuer les risques tels que les dérives et les hallucinations des modèles ? Dans l'affirmative, veuillez fournir des exemples. Avez-vous des suggestions sur la manière dont ces processus dérivés de la surveillance des systèmes de négociation algorithmique pourraient être adaptés aux systèmes d'IA pour les recommandations et les décisions de négociation ?

- Certains aspects du droit des valeurs mobilières exigent une documentation détaillée et une traçabilité de la prise de décision. Ce type d'enregistrement peut s'avérer difficile dans le contexte de l'utilisation de modèles reposant sur certains types de techniques d'IA. Quel niveau de transparence/explicabilité doit être intégré dans un système d'IA lors de sa conception, de sa planification et de sa construction pour que les résultats de ce système puissent être compris et expliqués par les humains ? Faut-il prévoir des règles et/ou des orientations nouvelles ou modifiées concernant l'utilisation d'un système d'IA moins explicable (par exemple, des garanties permettant de vérifier de manière indépendante la fiabilité des résultats) ?

- Les solutions FinTech qui s'appuient sur des systèmes d'IA proposant de fournir des services de KYC et d'onboarding, des conseils et d'effectuer une gestion discrétionnaire des investissements remettent en cause la dépendance actuelle à l'égard de personnes compétentes pour effectuer des activités enregistrables. Des aménagements réglementaires devraient-ils être apportés pour permettre de telles solutions et, dans l'affirmative, lesquels ? Quelles restrictions devraient être imposées pour fournir les mêmes résultats réglementaires et les mêmes garanties que ceux fournis par les exigences actuelles en matière de compétence imposées aux personnes physiques enregistrées ?

- Compte tenu de la capacité des systèmes d'IA à analyser une vaste gamme d'investissements potentiels, devrions-nous modifier nos attentes concernant les offres de produits et l'univers des alternatives raisonnables que les représentants doivent prendre en compte pour formuler des recommandations qui conviennent aux clients et placent les intérêts de ces derniers au premier plan ? Dans quelle mesure cette responsabilité élargie serait-elle onéreuse en termes de supervision et d'explication des systèmes d'IA utilisés ?

- Les participants au marché devraient-ils être assujettis à des règles supplémentaires concernant l'utilisation de produits ou de services de tiers qui reposent sur des systèmes d'IA ? Une fois qu'un tel produit ou service tiers est utilisé par un participant au marché, le fournisseur tiers devrait-il être soumis à des exigences et, le cas échéant, en fonction de quels facteurs ?

- L'utilisation accrue des systèmes d'IA sur les marchés de capitaux exacerbe-t-elle les vulnérabilités/risques systémiques existants ou en crée-t-elle de nouveaux ? Dans l'affirmative, veuillez préciser Les participants au marché adoptent-ils des mesures spécifiques pour atténuer les risques systémiques ? Devrait-il y avoir des règles nouvelles ou modifiées pour tenir compte de ces risques systémiques ? Dans l'affirmative, veuillez fournir des détails.

Voici quelques exemples de risques systémiques :

- Les systèmes d'IA travaillent de manière coordonnée pour obtenir un résultat souhaité, par exemple en créant des périodes de volatilité du marché afin de maximiser les profits ;

- L'utilisation généralisée de systèmes d'IA dépendant du même fournisseur ou d'un nombre limité de fournisseurs pour fonctionner (par exemple, fournisseurs de nuages ou de données), ce qui pourrait entraîner des risques de stabilité financière résultant d'une erreur importante ou d'une défaillance d'un grand fournisseur ;

- Un effet de troupeau en cas d'adoption massive d'un système d'IA unique ou lorsque plusieurs systèmes d'IA prennent des décisions d'investissement ou de négociation similaires, intentionnellement ou non, en raison, par exemple, d'une conception et de sources de données similaires. Cela pourrait entraîner des mouvements de marché amplifiés, y compris des mouvements préjudiciables si un système d'IA défectueux est largement utilisé ou est utilisé par un participant au marché important ;

- Biais systémiques généralisés dans les résultats des systèmes d'IA qui affectent le fonctionnement efficace et l'équité du capital

[1] Pour plus de clarté, cette série d'articles ne traite pas de l'avis en relation avec ses orientations pour les places de marché et les participants au marché, les agences de compensation et les services d'appariement, les référentiels centraux et les rapports sur les données relatives aux produits dérivés, les organisations de notation désignées et les administrateurs de référentiels désignés.

[2] Un "Système d'IA" est un système basé sur une machine qui, pour des objectifs explicites ou implicites, déduit, à partir des données qu'il reçoit, comment générer des résultats tels que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer des environnements physiques ou virtuels.

[3] Bureau du surintendant des institutions financières (BSIF) Guideline E-23 on Model Risk Management ; Organisation internationale de normalisation (ISO) : Normes pour l'intelligence artificielle (https://www.iso.org/artificial-intelligence) ; National Institute of Standards and Technology (NIST) Cadre de gestion des risques liés à l'IA (https://www.nist.gov/itl/ai-risk-management-framework).