AVIS ET CONSULTATION DU PERSONNEL DE L'ACS 11-348 LA RÉVOLUTION DE L'INFORMATIQUE : REDÉFINIR LE DROIT CANADIEN DES VALEURS MOBILIÈRES

PARTIE 1 - THÈMES GÉNÉRAUX

Brian Koscak, vice-président de la PCMA

Le 5 décembre 2024, les Autorités canadiennes en valeurs mobilières (les (CSA)) publié Avis et consultation du personnel du CSA 11-348 - Applicabilité des lois canadiennes sur les valeurs mobilières et utilisation des systèmes d'intelligence artificielle sur les marchés des capitaux (le Avis).

Cet article est le premier d'une série de trois articles :

- Partie 1 - Thèmes générauxqui aborde les grands thèmes identifiés par les ACVM, notamment la neutralité technologique dans la réglementation des valeurs mobilières, l'intelligence artificielle (AI), la gouvernance et la surveillance, les exigences en matière d'explicabilité, les obligations de divulgation et la gestion des conflits d'intérêts liés à l'IA ;

- Partie 2 - Conseils aux déclarants, qui traite de l'application spécifique de l'avis aux déclarants (e., les courtiers, les conseillers et les gestionnaires de fonds d'investissement (OIF) (et les fonds d'investissement de l'émetteur assujetti qu'ils gèrent) ; et

- Partie 3 - Directives à l'intention des émetteurs de rapports sur les fonds autres que les fonds d'investissementqui examine l'impact de la communication sur les émetteurs assujettis qui ne sont pas des fonds d'investissement.

A. Objet

L'objectif de l'avis est de fournir des éclaircissements et des orientations sur la manière dont la législation canadienne sur les valeurs mobilières s'applique à l'utilisation de la technologie "Systèmes d'IApar les participants au marché, y compris les personnes inscrites, les émetteurs assujettis autres que les fonds d'investissement, les places de marché, les participants au marché, les agences de compensation, les services d'appariement, les référentiels centraux, les organisations de notation désignées et les administrateurs de référence désignés (collectivement, les "participants au marché"), Participants au marché).

Le présent avis décrit certaines exigences en vertu des lois canadiennes sur les valeurs mobilières dont les participants au marché devraient tenir compte pendant le cycle de vie d'un système d'IA et fournit des indications sur la façon dont les ACVM interprètent les lois canadiennes sur les valeurs mobilières applicables dans ce contexte. En outre, les ACVM ont posé des questions de consultation afin de recueillir les commentaires des parties prenantes sur l'utilisation des systèmes d'IA sur les marchés financiers ; ces questions sont présentées à la fin de l'article.

B. Cycle de vie des systèmes d'IA

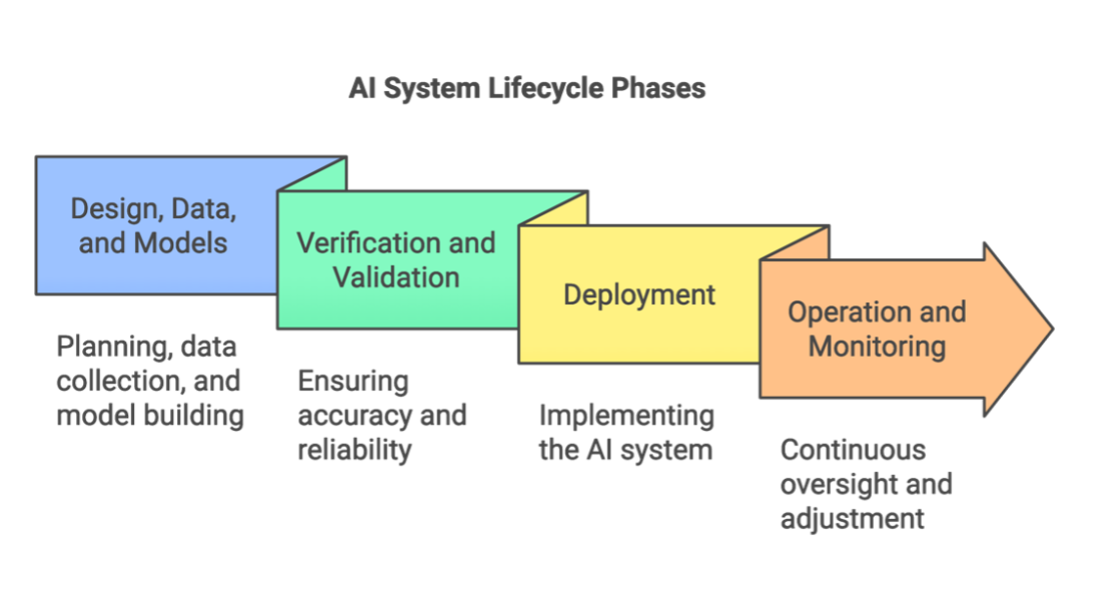

L'avis décrit certaines exigences en vertu des lois canadiennes sur les valeurs mobilières que les participants au marché devraient prendre en considération pendant le cycle de vie d'un système d'IA. Par souci de clarté, un "Cycle de vie d'un système d'IALe programme "L'Europe de l'Est" comporte quatre phases, qui sont également illustrées dans le diagramme ci-dessous.

La première phase, Conception, données et modèlesLa "phase initiale" est une séquence dépendant du contexte qui englobe les éléments fondamentaux de la planification et de la conception, de la collecte et du traitement des données, et de la construction de modèles. Cette phase initiale jette les bases du développement et de la fonctionnalité de l'ensemble du système.

La deuxième phase se concentre sur Vérification et validationLe système est soumis à des essais et à une évaluation approfondis afin de s'assurer qu'il répond à toutes les exigences nécessaires et qu'il fonctionne comme prévu. Cette étape cruciale permet d'identifier les risques potentiels et de garantir la conformité aux normes réglementaires.

La troisième phase, DéploiementLa phase de "mise en œuvre" comprend la mise en place effective du système d'IA dans l'environnement opérationnel, marquant la transition entre le développement et l'application pratique. Cette phase nécessite une attention particulière à l'intégration avec les systèmes existants et à la mise en place de contrôles appropriés.

La phase finale, Fonctionnement et suiviLa phase de "maintenance" représente l'entretien et la surveillance continus du système une fois qu'il est utilisé de manière active. Cette phase est cruciale pour garantir que le système continue à fonctionner efficacement et reste conforme aux exigences réglementaires au fil du temps. Un contrôle et des ajustements réguliers sont des éléments essentiels de cette phase.

Il est important de noter que ces phases ne sont pas toujours séquentielles, mais qu'elles se déroulent souvent de manière itérative, c'est-à-dire qu'elles peuvent se répéter ou se dérouler simultanément. Les orientations et l'appel à commentaires des CSA, ainsi que l'examen des questions posées dans l'avis, peuvent être influencés par l'étape du cycle de vie du système d'IA.

C. L'objectif de la CSA dans la publication de l'avis

En publiant l'avis, les ACVM visent à réglementer de manière proactive l'IA sur les marchés financiers, en encourageant l'innovation tout en protégeant les investisseurs. Les ACVM visent à soutenir un environnement dans lequel l'IA peut améliorer l'efficacité du marché et l'expérience des investisseurs tout en gérant les risques potentiels. L'objectif est de soutenir le développement responsable de l'IA au Canada, tout en atténuant les risques systémiques et en préservant l'équité et la transparence des marchés.

Comme l'indique l'avis de la CSA,

"Nous nous efforçons de soutenir un environnement dans lequel le déploiement des systèmes d'IA améliore l'expérience de l'investisseur tout en tenant compte du risque de préjudice pour l'investisseur ; où les marchés peuvent bénéficier des gains d'efficacité potentiels et de la concurrence accrue engendrés par l'utilisation des systèmes d'IA ; où le capital peut être investi dans des entreprises canadiennes qui développent des systèmes d'IA de manière responsable ; et où tout nouveau type de risque, y compris les risques systémiques, est traité de manière appropriée.." (2024), 47 OSCB 9307

D. Publications antérieures des CSA sur l'IA et les marchés financiers canadiens

Les ACVM cherchent à harmoniser leur approche de la réglementation de l'IA tant au niveau national qu'international. Voici quelques exemples de publications récentes des membres de l'ASC sur l'IA et les marchés financiers :

- L'intelligence artificielle sur les marchés financiers : Explorer les cas d'utilisation en Ontario

- Intelligence artificielle et investissement de détail : Escroqueries et contre-mesures efficaces

- Intelligence artificielle et investissement de détail : Cas d'utilisation et recherche expérimentale

- Document de réflexion et de discussion - Bonnes pratiques pour une utilisation responsable de l'IA dans le secteur financier

Les ACVM collaborent également au niveau international avec des organisations telles que l'Organisation internationale des commissions de valeurs (OICV) afin d'aligner les normes mondiales. L'avis précise que la FinTech Taskforce de l'OICV explore activement les risques et les opportunités de l'IA sur les marchés de capitaux et élabore des outils et des recommandations à l'intention de ses membres.

E. Objet de l'article

L'avis est divisé en trois parties :

- Thèmes généraux - les thèmes généraux qui s'appliquent à l'utilisation des systèmes d'IA sur les marchés de capitaux par l'ensemble des participants au marché ;

- Identification et application des lois sur les valeurs mobilières - l'identification de lois et de directives spécifiques sur les valeurs mobilières et la manière dont elles s'appliquent aux différents participants au marché au Canada ; et

- Questions de consultation - L'avis comporte 10 questions de consultation, comme indiqué à la fin de cet article, dans lesquelles les ACVM demandent aux parties prenantes de faire part de leurs commentaires sur l'utilisation qu'elles font des systèmes d'IA sur les marchés financiers. Les ACVM sollicitent les commentaires du secteur au plus tard le 30 mars 2025..

F. Thèmes généraux relatifs à l'utilisation des systèmes d'IA

Les différents thèmes primordiaux identifiés par la CSA sont les suivants :

a. Technologie et réglementation des valeurs mobilières

Le principe de base des ACVM est que les lois sur les valeurs mobilières sont neutres sur le plan technologique ; cependant, toutes les technologies ne sont pas traitées de la même manière. C'est comme si l'on appliquait les mêmes règles de santé et de sécurité à une cuisine familiale et à un restaurant commercial. Si les principes généraux, tels que la propreté et la sécurité alimentaire, restent les mêmes, une cuisine commerciale nécessite des protocoles supplémentaires, tels que des inspections et des normes d'équipement spécialisées, en raison de sa taille et de sa complexité. De même, alors que les lois sur les valeurs mobilières s'appliquent à toutes les technologies, l'IA introduit des défis uniques, tels que la transparence algorithmique, la partialité et la sécurité des données, nécessitant des approches spécifiques pour s'assurer que ces risques sont traités, tout en maintenant les protections des investisseurs.

L'avis souligne que ce n'est pas la technologie elle-même qui est réglementée, mais les activités menées au moyen de cette technologie. Cette distinction est cruciale car elle permet au cadre réglementaire de s'adapter à l'évolution des systèmes d'IA et de la technologie. Les ACVM n'essaient pas de réglementer les algorithmes ; elles réglementent ce que ces algorithmes font dans le contexte des marchés des valeurs mobilières.

Plus important encore, les ACVM soulignent que la législation sur les valeurs mobilières fondée sur des principes peut s'adapter à l'innovation technologique. Les cadres existants peuvent être suffisamment souples pour s'adapter aux nouvelles technologies tout en conservant leur fonction protectrice.

b. Gouvernance et supervision de l'IA

Les ACVM déclarent que la gouvernance et la gestion des risques doivent être une priorité absolue pour les participants au marché lorsqu'ils déploient des systèmes d'IA. Ils s'attendent à une surveillance rigoureuse sans imposer de technologies ou de structures spécifiques. L'exigence d'une "l'homme dans la boucle"Il ne s'agit pas seulement d'avoir quelqu'un qui surveille les machines, mais plutôt d'assurer un contrôle humain significatif.

La CSA décrit les éléments spécifiques qui devraient être inclus dans les cadres de gouvernance de l'IA, depuis la planification et la conception initiales jusqu'au contrôle et à la validation continus. Il s'agit d'une approche globale qui reconnaît que les systèmes d'IA ne sont pas des outils statiques, mais des entités en évolution qui nécessitent une surveillance continue. L'accent mis sur la connaissance de l'IA chez les utilisateurs est remarquable, car la CSA affirme qu'il ne suffit pas d'avoir la technologie, il faut aussi des personnes qui comprennent comment l'utiliser de manière responsable.

En clair, les ACVM ne se contentent pas de dire "gouvernez votre IA", elles fournissent une sorte de feuille de route sur la manière de le faire. L'avis fournit des étapes spécifiques et réalisables pour la mise en place de cadres de gouvernance de l'IA, abordant des aspects importants allant de l'exactitude des données utilisées à la supervision minutieuse des fournisseurs de services tiers.

c. Explicabilité

La CSA stipule en substance que si vous ne pouvez pas expliquer comment votre IA a pris une décision, vous ne devriez probablement pas l'utiliser. Dans un monde où de nombreux systèmes d'IA génèrent leurs résultats de recherche sans montrer leur travail, la CSA exige la transparence. La CSA précise que la transparence d'un système d'IA dépend de l'ouverture de son fonctionnement interne. Comme l'indique la CSA, la transparence d'un système d'IA dépend de l'ouverture de son fonctionnement interne,

"Un système d'IA transparent fournit des informations claires sur son architecture, ses sources de données et ses algorithmes. Toutefois, la transparence ne garantit pas à elle seule que les résultats du système soient facilement compréhensibles par les humains. Alors qu'un système peut être transparent mais avoir une faible explicabilité (décisions complexes et difficiles à interpréter), un modèle à forte explicabilité favorise intrinsèquement la transparence. En effet, les modèles explicables permettent aux utilisateurs de comprendre plus facilement le processus par lequel leurs résultats ont été générés, ce qui renforce la confiance dans le système d'IA.."

Les ACVM s'attendent à ce que les participants au marché donnent la priorité à l'IA explicable, même si des systèmes plus opaques peuvent offrir de meilleures performances.

Le thème de l'explicabilité s'attaque de front au défi de " l'explicabilité ".boîte noire" Systèmes d'IA (c'est-à-dire, ceux dont les processus de décision sont si complexes qu'ils sont en fait incompréhensibles pour les humains). La position du CSA est claire : "... la nécessité de disposer de capacités avancées doit être mise en balance avec la nécessité d'être explicable". Cette approche reconnaît le compromis entre la sophistication de l'IA et la transparence, et privilégie résolument la compréhension plutôt que les performances brutes.

Ce qui rend ce thème important, c'est le défi implicite qu'il lance au secteur de la technologie financière. En insistant sur l'explicabilité, l'ASC dit effectivement aux développeurs et aux institutions qu'ils doivent construire des systèmes d'IA différents, qui privilégient la transparence et l'interprétabilité dès le départ.

Il reste à voir comment les parties prenantes réagiront à cette exigence de la CSA, d'autant plus que la CSA semble limiter les systèmes d'IA à l'exécution d'algorithmes basés sur des règles, sans sembler reconnaître leur potentiel d'interprétation et de prise de décision de manière peu transparente.

d. Divulgation

L'approche de la CSA en matière de divulgation constitue une remise en cause directe de l'approche "Lavage à l'IALes marchés financiers sont en train d'être bouleversés par l'apparition d'un phénomène de "surchauffe" dans certains secteurs. Comme son homologue environnemental "écoblanchimentLa CSA exige que des informations spécifiques et précises soient fournies sur la manière dont l'IA est réellement utilisée, et non de vagues promesses de solutions "alimentées par l'IA". La CSA exige des informations spécifiques et précises sur la manière dont l'IA est réellement utilisée, et pas seulement de vagues promesses de solutions "alimentées par l'IA".

Les exigences de ce thème vont au-delà de la simple vérité dans la publicité. Les ACVM s'attendent à ce que les participants au marché fournissent aux investisseurs suffisamment d'informations pour qu'ils comprennent non seulement que l'IA est utilisée, mais aussi comment elle est utilisée et quels risques cette utilisation comporte. Ce niveau de transparence pourrait changer la façon dont les institutions financières commercialisent leurs capacités en matière d'IA.

Plus important encore, les obligations d'information s'appliquent à tous les types de communication, des documents d'offre officiels aux documents de marketing et aux accords avec les clients. Les ACVM affirment en fait que toute allégation relative à l'utilisation de l'IA doit être étayée par des éléments concrets (c'est-à-dire, Cette exigence pourrait permettre de distinguer une véritable innovation en matière d'IA d'une simple façade technologique.

e. Conflits d'intérêts

Le traitement par la CSA des conflits liés à l'IA part du principe que les algorithmes peuvent créer de nouveaux types de conflits que les cadres traditionnels risquent de ne pas voir. Qu'il s'agisse d'ensembles de données biaisés ou de codes défectueux favorisant certains résultats, les systèmes d'IA peuvent introduire des distorsions subtiles qui pourraient ne pas être immédiatement visibles pour les superviseurs humains.

Ce qui rend ce thème particulièrement puissant, c'est qu'il reconnaît que les conflits liés à l'IA nécessitent de nouvelles approches en matière de surveillance. L'avis recommande des mécanismes spécifiques pour détecter et gérer ces conflits, notamment l'utilisation de systèmes d'IA pour surveiller d'autres systèmes d'IA, une sorte d'équilibre des pouvoirs technologique. Il s'agit d'une approche sophistiquée qui reconnaît à la fois la complexité des conflits liés à l'IA et le potentiel des solutions technologiques.

Les exigences en matière de gestion des conflits vont au-delà de la divulgation ou de l'évitement. Les ACVM s'attendent à une surveillance et à une gestion actives des conflits liés à l'IA. Elles veulent s'assurer que les systèmes automatisés ne prennent pas de décisions qui favorisent systématiquement les intérêts des participants au marché au détriment de ceux de leurs clients/investisseurs.

Prochaines étapes

L'avis représente une étape importante dans l'adaptation de la réglementation des valeurs mobilières à l'ère de l'IA, en établissant des principes fondamentaux à travers ses thèmes principaux de réglementation neutre sur le plan technologique, de gouvernance solide, d'exigences d'explicabilité, de divulgation transparente et de gestion des conflits. Ces thèmes ouvrent la voie à des orientations plus détaillées spécifiques aux différents acteurs du marché.

La deuxième partie de cette série examine comment la communication s'applique spécifiquement aux courtiers, aux conseillers et aux GFI.

La période de consultation de la CSA se termine le 30 mars 2025. La consultation donne aux parties prenantes du secteur l'occasion de contribuer à l'évolution de la réglementation de l'IA sur les marchés financiers canadiens. Par ce processus de consultation, les ACVM cherchent à favoriser l'innovation responsable en matière d'IA tout en maintenant l'intégrité du marché et la protection des investisseurs. Les questions de la consultation sont présentées ci-dessous.

Avis CSA Questions de consultation

1. Existe-t-il des cas d'utilisation des systèmes d'IA qui, selon vous, ne peuvent être pris en compte sans règles nouvelles ou modifiées, ou sans exemptions ciblées des règles actuelles ? Veuillez préciser les changements que vous jugez nécessaires.

2. Faut-il prévoir des règles et/ou des orientations nouvelles ou modifiées pour traiter les risques liés à l'utilisation des systèmes d'IA sur les marchés de capitaux, notamment en ce qui concerne les approches de gestion des risques pour le cycle de vie des systèmes d'IA ? Les entreprises doivent-elles élaborer de nouveaux cadres de gouvernance ou peuvent-elles adapter les cadres existants ? Devrions-nous envisager d'adopter des mesures ou des normes de gouvernance spécifiques (par exemple, la ligne directrice E-23 du BSIF sur la gestion du risque de modèle, l'ISO, le NIST) ?

3. Les données jouent un rôle essentiel dans le fonctionnement des systèmes d'IA et constituent la base sur laquelle leurs résultats sont créés. Quelles considérations les participants au marché devraient-ils garder à l'esprit lorsqu'ils déterminent les sources de données à utiliser pour les systèmes d'IA qu'ils déploient (p. ex. la confidentialité, l'exactitude, l'exhaustivité) ? Quelles mesures les participants au marché devraient-ils prendre lorsqu'ils utilisent des systèmes d'IA afin de tenir compte des risques uniques liés aux sources de données utilisées par les systèmes d'IA (p. ex. des mesures qui amélioreraient la confidentialité, l'exactitude, la sécurité, la qualité et l'exhaustivité des données) ?

4. Quel rôle les humains devraient-ils jouer dans la surveillance des systèmes d'IA (par exemple, "l'humain dans la boucle") et comment ce rôle devrait-il être intégré dans le cadre de gouvernance de l'IA d'une entreprise ? Y a-t-il certaines utilisations des systèmes d'IA sur les marchés de capitaux pour lesquelles l'implication humaine directe dans la surveillance des systèmes d'IA est plus importante que d'autres (par exemple, les cas d'utilisation reposant sur des techniques d'apprentissage automatique qui peuvent avoir des degrés d'explicabilité moindres) ? En fonction du système d'IA, quelles sont les compétences, les connaissances, la formation et l'expertise nécessaires ? Veuillez fournir des détails et des exemples.

5. Est-il possible de surveiller efficacement et en permanence les systèmes d'IA afin d'identifier les variations dans les résultats des modèles à l'aide d'un développement fondé sur des tests, y compris des tests de résistance, des examens post-négociation, des vérifications ponctuelles et des mesures correctives, de la même manière que pour les algorithmes de négociation fondés sur des règles, afin d'atténuer les risques tels que les dérives et les hallucinations des modèles ? Dans l'affirmative, veuillez fournir des exemples. Avez-vous des suggestions sur la manière dont ces processus dérivés de la surveillance des systèmes de négociation algorithmique pourraient être adaptés aux systèmes d'IA pour les recommandations et les décisions de négociation ?

6. Certains aspects du droit des valeurs mobilières exigent une documentation détaillée et une traçabilité de la prise de décision. Ce type d'enregistrement peut s'avérer difficile dans le contexte de l'utilisation de modèles reposant sur certains types de techniques d'IA. Quel niveau de transparence/explicabilité doit être intégré dans un système d'IA lors de sa conception, de sa planification et de sa construction pour que les résultats de ce système puissent être compris et expliqués par les humains ? Faut-il prévoir des règles et/ou des orientations nouvelles ou modifiées concernant l'utilisation d'un système d'IA moins explicable (par exemple, des garanties permettant de vérifier de manière indépendante la fiabilité des résultats) ?

7. Les solutions FinTech qui s'appuient sur des systèmes d'IA proposant de fournir des services de KYC et d'onboarding, des conseils et d'effectuer une gestion discrétionnaire des investissements remettent en cause la dépendance actuelle à l'égard de personnes compétentes pour effectuer des activités enregistrables. Des aménagements réglementaires devraient-ils être apportés pour permettre de telles solutions et, dans l'affirmative, lesquels ? Quelles restrictions devraient être imposées pour fournir les mêmes résultats réglementaires et les mêmes garanties que ceux fournis par les exigences actuelles en matière de compétence imposées aux personnes physiques enregistrées ?

8. Compte tenu de la capacité des systèmes d'IA à analyser une vaste gamme d'investissements potentiels, devrions-nous modifier nos attentes concernant les gammes de produits et l'univers des alternatives raisonnables que les représentants doivent prendre en compte pour formuler des recommandations qui conviennent aux clients et qui placent les intérêts de ces derniers au premier plan ? Dans quelle mesure cette responsabilité élargie serait-elle onéreuse en termes de supervision et d'explication des systèmes d'IA utilisés ?

9. Les participants au marché devraient-ils être assujettis à des règles supplémentaires concernant l'utilisation de produits ou de services de tiers qui reposent sur des systèmes d'IA ? Une fois qu'un tel produit ou service de tiers est utilisé par un participant au marché, le fournisseur tiers devrait-il être assujetti à des exigences et, dans l'affirmative, en fonction de quels facteurs ?

10. L'utilisation accrue des systèmes d'IA sur les marchés de capitaux exacerbe-t-elle les vulnérabilités/risques systémiques existants ou en crée-t-elle de nouveaux ? Dans l'affirmative, veuillez les décrire. Les participants au marché adoptent-ils des mesures spécifiques pour atténuer les risques systémiques ? Devrait-il y avoir des règles nouvelles ou modifiées pour tenir compte de ces risques systémiques ? Dans l'affirmative, veuillez fournir des détails.

Voici quelques exemples de risques systémiques :

- Les systèmes d'IA travaillent de manière coordonnée pour obtenir un résultat souhaité, par exemple en créant des périodes de volatilité du marché afin de maximiser les profits ;

- L'utilisation généralisée de systèmes d'IA dépendant du même fournisseur ou d'un nombre limité de fournisseurs pour fonctionner (par exemple, fournisseurs de données ou de nuages), ce qui pourrait entraîner des risques de stabilité financière résultant d'une erreur importante ou d'une défaillance d'un grand fournisseur ;

- Un effet de troupeau en cas d'adoption massive d'un système d'IA unique ou lorsque plusieurs systèmes d'IA prennent des décisions d'investissement ou de négociation similaires, intentionnellement ou non, en raison, par exemple, d'une conception et de sources de données similaires. Cela pourrait entraîner des mouvements de marché amplifiés, y compris des mouvements préjudiciables si un système d'IA défectueux est largement utilisé ou est utilisé par un participant au marché important ;

- Biais systémiques généralisés dans les résultats des systèmes d'IA qui affectent le fonctionnement efficace et l'équité des marchés financiers.